Nguồn: https://netflixtechblog.com/what-is-an-a-b-test-b08cc1b57962

Phần 1: https://blog.haonheo.com/cac-tao-ra-quyet-dinh-tai-netflix/

Đây là bài thứ 2 về loạt bài dài kỳ về phương pháp Netflix dùng A/B test để kiểm tra các quyết định và liên tục cải tiến sản phẩm. Bài này sẽ đi vào chi tiết về các thống kê, thử nghiệm về mặt sản phẩm, cách Netflix đầu tư vào cơ sở hạ tầng để hỗ trợ và mở rộng việc thử nghiệm, tầm quan trọng của văn hóa thử nghiệm.

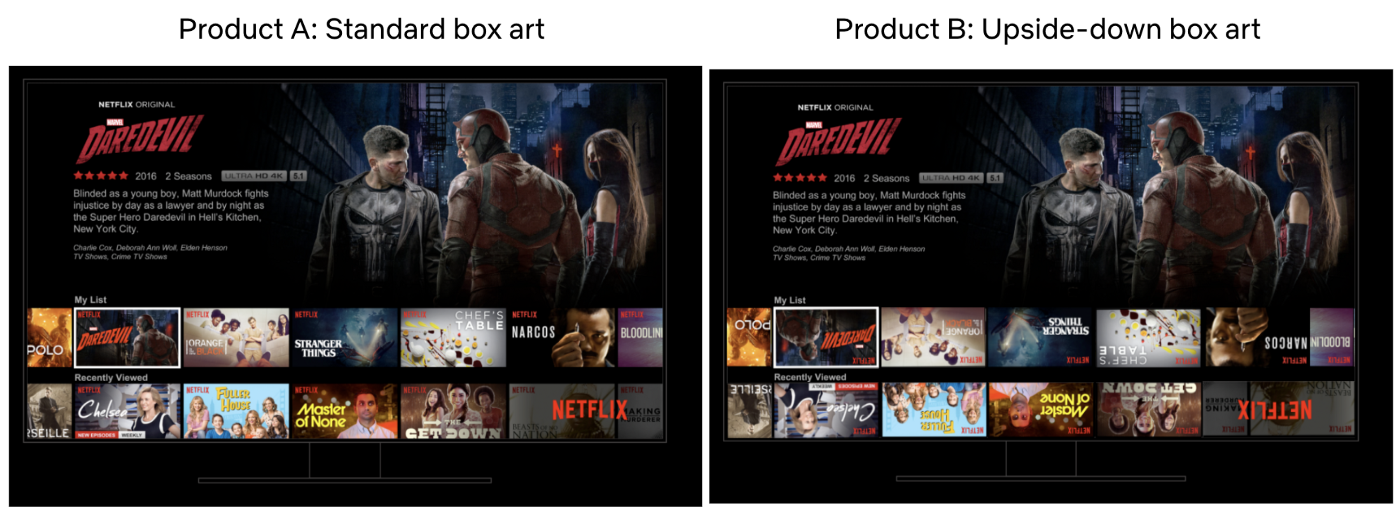

A/B test là một quá trình có thể kiểm chứng đơn giản. Ví dụ bạn muốn kiểm chứng xem việc lật ngược ảnh đại diện của phim có tăng cường trải nghiệm người dùng hay không.

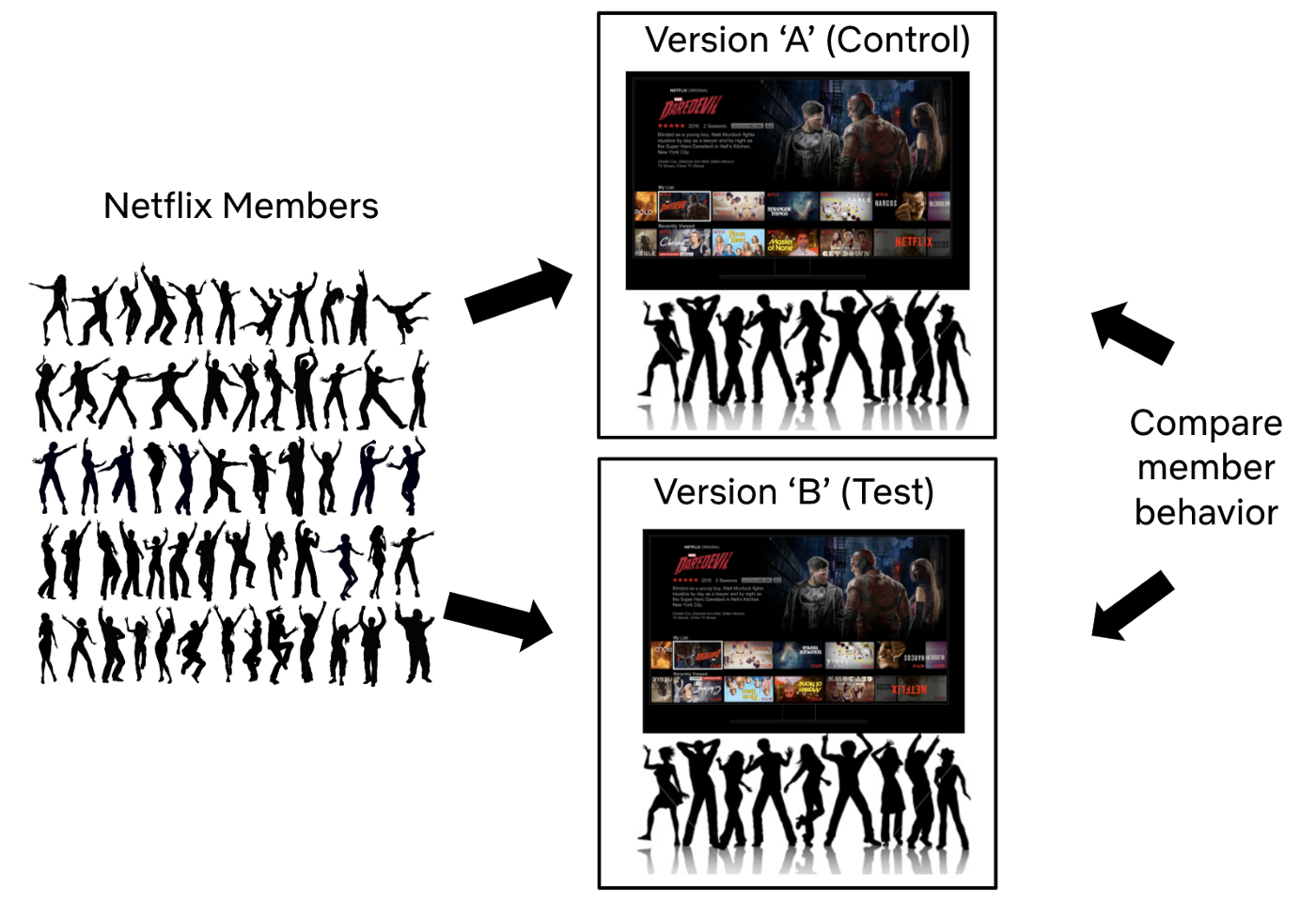

Để thử nghiệm, chúng tôi lấy 1 tập khách hàng, thường là một tập ngẫu nhiên, Sau đó phân loại ngẫu nhiên để chia thành 2 nhóm như nhau. Nhóm A gọi là nhóm kiểm chứng, nhóm B gọi là nhóm thử nghiệm, nhóm B sẽ nhận 1 trải nghiệm người dùng khác đi – dựa trên 1 giả thuyết để kiểm chứng xem có tối ưu hơn hay không. Ở đây nhóm B sẽ được thử nghiệm lật ngược ảnh đại diện các bộ phim.

Chúng tôi thử nghiệm và chờ, sau đó so sánh các thông số của nhóm A và B. Vài thông số sẽ được tính là thông số đặc trưng của thử nghiệm đó. Để đo lường trải nghiệm chúng tôi xem xét ở nhiều góc độ. Ví dụ với 1 thử nghiệm hướng tới việc đưa ra nhiều kết quả liên quan trong trải nghiệm tìm kiếm, chúng tôi sẽ đo lường xem người dùng có tìm được nhiều nội dung muốn xem hay không. Ở các thử nghiệm khác, chúng tôi có thể sẽ tập trung hơn vào các thông số kỹ thuật như thời gian ứng dụng chờ tải nội dung, chất lượng video khi người dùng xem ở các điều kiện mạng khác nhau.

Với rất nhiều thử nghiệm khác nhau, chúng tôi phải suy nghĩ cẩn thận các thông số đang nói lên câu chuyện gì. Ví dụ nếu chúng ta nhìn vào số lượng click, đo xem tập người dùng nào thực sự chọn xem nội dung đó thì nếu chỉ xem xét chỉ số lượt xem có thể bạn sẽ đánh giá sai. Vì có thể người dùng nhấn vào các ảnh đại diện bị lật ngược chỉ để vào thông tin chi tiết để đọc dễ hơn, với trường hợp này chúng ta nên đánh giá luôn tập người dùng nào thực sự xem nội dung hay thoát luôn.

Trong tất cả các trường hợp, chúng tôi phải nhìn vào các thông số tổng thể hướng tới việc đo lường sự thỏa mãn của người dùng khi sử dụng. Những thông số trên bao gồm các thước đo tương tác giữa người dùng với Netflix, xem xét xem ý tưởng mới chúng tôi đang thử nghiệm có khiến người dùng muốn xem Netflix hàng đêm hay không ?

Có rất nhiều thống kê phải xem xét trong cả quá trình. Ví dụ sự chênh lệch giữa các nhóm như thế nào mới được xem là đủ ? Bao nhiêu người dùng cần tham gia vào thử nghiệm để nhận ra sự ảnh hưởng của tính năng mới ? Làm sao đánh giá được dữ liệu hiệu quả ? Chúng tôi sẽ nói về các vấn đề đó ở phần sau.

Giữ mọi thứ khác ổn định

Vì chúng tôi tạo ra nhóm A và B một cách ngẫu nhiên, cần đảm bảo rằng người dùng ở cả 2 tập phải cân bằng ở các góc độ ý nghĩa với việc thử nghiệm. Ví dụ như độ dài của các gói thành viên, ngôn ngữ sử dụng, nội dung thường xem … ở 2 tập người dùng không được quá khác nhau. Sự khác nhau duy nhất được phép là những thứ chúng tôi muốn thử nghiệm.

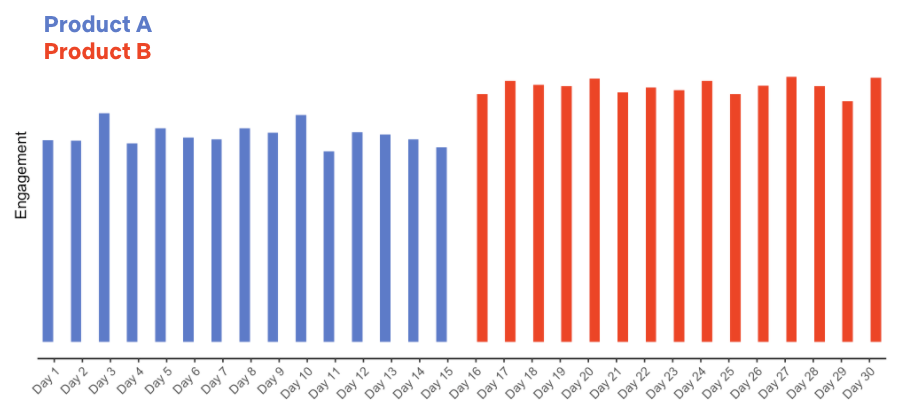

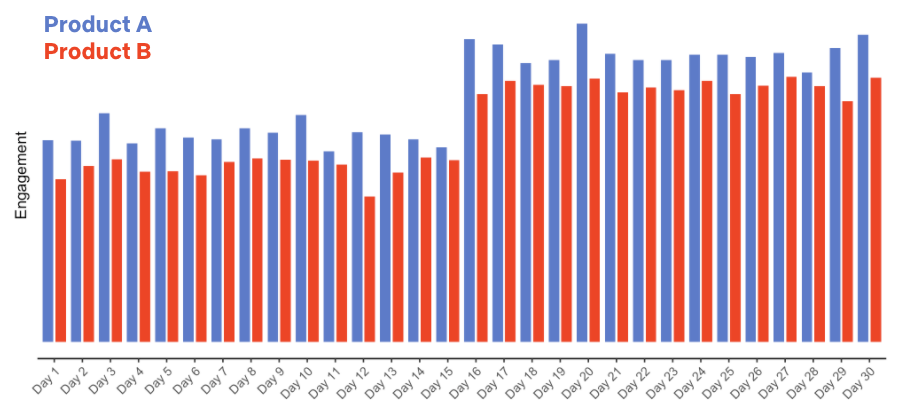

Để hiểu tầm quan trọng của việc này, hãy giả định chúng tôi làm theo cách là thử nghiệm trên toàn bộ người dùng Netflix xem có thay đổi lớn nào không. Nếu thay đổi tích cực thì giữ trải nghiệm mới, nếu tiêu cực thì quay lại trả nghiệm cũ. Ví dụ chúng tôi bắt đầu thử nghiệm vào ngày 16 và thu được dữ liệu như sau

Trông có vẻ tốt, tương tác người dùng tăng trông thấy. Nhưng bạn có chắc chắn là trải nghiệm mới tốt hơn hay không ? Bạn có chắc chắn trải nghiệm mới là thứ duy nhất đóng góp vào sự tăng trưởng này hay có 1 cách giải thích nào đó khác ?

Nếu thực ra sự tăng trưởng đó tới từ việc Netflix ra mắt phim mới ví dụ như 1 phần mới của Stranger Things hoặc Bridgerton vào cùng ngày 16 ? Đó là những dữ kiện mà chúng ta không chắc có ảnh hưởng tới thử nghiệm hay không.

Giả sử thay vì thí nghiệm như trên chúng ta thử với 2 tập khách hàng khác nhau (1 tập kiểm chứng và 1 tập thử nghiệm) và có được kết quả như sau.

Ở thử nghiệm này chúng ta có thể kết luận rằng người dùng tổng thể tăng do Netflix ra mắt các phim mới và trải nghiệm ở nhóm B làm giảm lượt người dùng tương tác.

A/B test giúp chúng tôi kết luận 1 cách chính xác vì chúng tôi chỉ cho nhóm B dùng trải nghiệm mới, ngoài ra chúng tôi phân loại ngẫu nhiên tập người dùng A và B, những thông số còn lại là như nhau nên khả năng cao là trải nghiệm đó làm giảm tương tác từ người dùng.

Kết luận này nghe có vẻ cực đoan nhưng bài học nhận được là luôn có những thứ chúng ta không thể đối chứng được nếu đưa trải nghiệm mới tới tất cả người dùng và chỉ đơn giản đánh giá con số trước và sau thay đổi. 2 khoảng thời gian chúng tôi thử nghiệm sẽ luôn có các biến số ngẫu nhiên ví dụ như ra mắt phim mới hoặc có sản phẩm mới làm người dùng hứng thú hơn. Luôn có những thứ chúng tôi không biết. Sử dụng A/B test giúp chúng tôi tự tin cải tiến sản phẩm vì biết rằng những thử nghiệm đó đã được người dùng trực tiếp lựa chọn.

Tất cả bắt đầu với 1 ý tưởng

Một thử nghiệm A/B bắt đầu với ý tưởng ví dụ như vài thay đổi về mặt giao diện, cá nhân hóa hệ thống tìm kiếm, luồng đăng ký người dùng mới hoặc bất kỳ phần nào của trải nghiệm chúng tôi tin là mang tới hiệu ứng tích cực cho người dùng. Vài ý tưởng là cải tiến, vài ý tưởng làm tính năng mới hoàn toàn như thử nghiệm tính năng “Top 10“.

Giống như các cải tiến ra mắt người dùng toàn cầu, tính năng Top 10 bắt đầu với ý tưởng mà chúng tôi đã chuyển thành thử nghiệm. Tư tưởng chủ đạo là hiển thị các nội dung phổ biến ở mỗi quốc gia để:

- Giúp người dùng chia sẻ trải nghiệm và kết nối với người dùng khác thông qua trao đổi về các nội dung đó.

- Giúp người dùng chọn nội dung hay bằng cách thúc đẩy bản năng của con người là muốn tham gia vào các cuộc trao đổi chung.

Chúng tôi biến ý tưởng này thành giả thuyết có thể thử nghiệm được bằng mẫu sau “nếu chúng ta thay đổi X, nó sẽ tăng trải nghiệm người dùng làm cho thông số Y được cải thiện“. Với ví dụ Top 10 trên chúng ta sẽ diễn giải như sau “Hiển thị Top 10 sẽ giúp người dùng dẽ dàng tìm nội dung để xem, tăng trải nghiệm vui vẻ và thỏa mãn“. Thước đo quyết định cho bài thử nghiệm này (và rất nhiều bài thử nghiệm khác) là thông qua định lượng tương tác của người dùng: Ý tưởng mới liệu có khiến người dùng muốn dùng Netflix hàng đêm không ? Theo nghiên cứu của chúng tôi thì thông số này tỉ lệ thuận về dài hạn với tỉ lệ người dùng tiếp tục trả phí gia hạn thành viên. Những bài thử nghiệm cho các tính năng khác như cài thiện trải nghiệm đăng ký hay thay đổi hạ tầng máy chủ đo lường những thông số khác nhưng nguyên lý vẫn không thay đổi: thứ đo lường trong các bài test có hướng tới tăng giá trị cho người dùng trong dài hạn hay không ?

Cùng với các thông số đo lường chính, chúng tôi cũng tính tới vài thông số phụ khác và cách chúng bị ảnh hưởng bởi chức năng chúng tôi đang thử nghiệm. Mục đích ở đây là để làm rõ luồng trải nghiệm, từ cách hành vi người dùng thay đổi vì bị ảnh hưởng bởi thử nghiệm mới.

Bằng cách kết nối các dữ kiện giữa việc thử nghiệm và các thông số đo lường chính, kèm theo việc theo dõi các thông số phụ giúp chúng tôi tự tin là bất kỳ sự thay đổi nào ở các thông số đo lường chính đều là kết quả chính của các thử nghiệm đang tiến hành chứ không phải là tác dụng phụ của chúng. Giả sử với chức năng Top 10, lượt tương tác là thông số đo lường chính nhưng chúng tôi cũng xem xét các thông số phụ như người dùng có xem từng nội dung trong top 10 mà chúng tôi gợi ý hay không, tỉ lệ giữa việc xem 1 nội dung từ top 10 và cũng nội dung đó nhưng ở các phần khác của giao diện. Nếu mục Top 10 thực sự tốt dựa theo giả thuyết ban đầu thì chắc chắn nhóm thử nghiệm sẽ xem nhiều hơn các nội dung ở Top 10 đó so với nhóm kiểm chứng.

Có thể không phải tất cả thử nghiệm của chúng tôi đều đúng (thỉnh thoảng còn có cả lỗi nữa) nên chúng tôi cũng phải xem xét vài chỉ số đóng vai trò như chỉ số bảo vệ. Mục tiêu của chúng tôi luôn là hạn chế các hậu quả đáng tiếc và đảm bảo trải nghiệm người dùng không để lại các tác động xấu tới người dùng. Ví dụ chúng tôi có thể so sánh tần suất sử dụng dịch vụ chăm sóc khách hàng cho cả 2 nhóm để đảm bảo chức năng mới không làm tăng con số này, việc này có thể cho thấy chức năng mới gây nhầm lẫn hoặc không làm người dùng hài lòng.

Tổng kết

Bài viết này tập trung vào các điểm cơ bản của A/B test, tại sao nên chạy A/B test thay vì áp dụng tính năng mới cho toàn bộ người dùng và chỉ xem xét các con số trước và sau thay đổi đó, cách chúng ta biến ý tưởng thành 1 bài test cụ thể. Ở bài 3 (mà tui sắp dịch) chúng ta sẽ đi vào các mô hình thống kê cơ bản khi muốn so sánh giữa 2 nhóm A/B.